Il est commode de renuméroter les états d'une chaîne absorbante, en

plaçant d'abord les états non absorbants, ensuite les états

absorbants. Dans ce cas, on dira que la matrice de transition est écrite

sous forme canonique

D´EMONSTRATION.

Soit

un état non absorbant (

). L'élément de matrice

de

est la probabilité de se trouver dans l'état non

absorbant

, après

pas, partant de

. Par conséquent,

est inférieur ou égal à la probabilité de ne par avoir

atteint d'état absorbant en

pas. Soit

|

(3.49) |

le nombre minimal de pas nécessaire à atteindre un état absorbant

depuis

. Soit

|

(3.50) |

la probabilité de ne pas atteindre d'état absorbant en

pas,

partant de

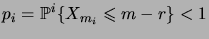

. Soit enfin

|

(3.51) |

Alors la probabilité de ne pas atteindre d'état absorbant en

pas,

partant de n'importe quel état non absorbant, est bornée par

. Il

suit que la probabilité de ne pas atteindre d'état absorbant en

pas est bornée par

. Cette probabilité tend vers 0 lorsque

tend vers l'infini. La probabilité de ne pas être absorbé après un

nombre arbitraire

de pas étant une fonction décroissante de

, elle tend nécessairement vers 0. Par conséquent,

tend vers zéro lorsque

tend vers l'infini, pour tout

.

![\begin{definition}[Cha\^\i ne de Markov absorbante]\hfill

\begin{itemiz}

\item U...

...i ne non absorbante est dite\/ \defwd{transiente}.

\end{itemiz}\end{definition}](img649.png)

![]() permet de déterminer le nombre

moyen de passages dans chaque état non absorbant, avant de finir par

atteindre un état absorbant.

permet de déterminer le nombre

moyen de passages dans chaque état non absorbant, avant de finir par

atteindre un état absorbant.

![]() , on obtient

, on obtient